Die Kombination aus k0rdent Enterprise und k0rdent Virtualization von Mirantis realisiert Kubernetes-natives Infrastrukturmanagement für Cloud-, Hybrid- und Edge-Szenarien. Plattformteams verwenden deklarative Infrastrukturbeschreibungen, GitOps-Pipelines und zentrale Richtlinien, um Deployments automatisiert durchzuführen. Ein intelligenter Scheduler optimiert Ressourcenzuweisung zwischen KI-Workloads, Microservices und VM-basierten Legacy-Anwendungen. Self-Service-Vorlagen reduzieren Wartezeiten für Entwickler. Das Resultat ist eine einheitliche, skalierbare Plattform, die Komplexität minimiert, Kosten senkt und Time-to-Value für neue Services drastisch verkürzt und steigert damit langfristige Wettbewerbsfähigkeit.

Inhaltsverzeichnis: Das erwartet Sie in diesem Artikel

Kubernetes-native Kontroll-Ebene vereint KI, Container und virtuelle Workloads effizient

Shaun O’Meara, Chief Technology Officer bei Mirantis (Foto: Mirantis)

Mit k0rdent Enterprise entsteht eine einheitliche Steuerungsebene, die KI-Dienste, Container-Orchestrierung und Virtualisierungs-Workloads unter Kubernetes vereint. Insellösungen werden dadurch beseitigt, während das Operations-Team von einer zentralen Konsole profitiert. Über deklarative Automatisierung und Self-Service-Templates lassen sich Deployments, Skalierung und Updates ohne manuelles Eingreifen durchführen. So gewinnen Unternehmen an Agilität und Kontrolle, reduzieren komplexe Verwaltungsaufwände und sorgen für eine konsistente, sichere Betriebsumgebung über sämtliche Workloads hinweg. Die Lösung unterstützt multi-regionale Deployments, rollenbasiertes Access-Management.

Horizontale Skalierung und Self-Healing sichern Infrastrukturverfügbarkeit ohne manuelles Eingreifen

Die Kubernetes-Orchestrierung automatisiert den kompletten Lifecycle von Containern und virtuellen Maschinen, einschließlich Deployment, horizontaler Skalierung und Ausfallsicherung. Plattform-Engineering-Teams profitieren von Self-Healing-Funktionen, die automatisch fehlerhafte Instanzen ersetzen, und von deklarativen Updates, die konsistente Zustandsbeschreibungen in YAML vorhalten. Vordefinierte GitOps-Pipelines integrieren Versionskontrolle und CI/CD-Tools und führen Deployments revisionssicher aus. Dadurch verringert sich der manuelle Aufwand, während die Reproduzierbarkeit und Agilität bei Rollouts und Updates deutlich steigen. Auf diese Weise lassen sich komplexe Anwendungsszenarien skalierbar betreiben und schneller auf Geschäftsanforderungen anpassen.

Dynamische Speicher und CPU-Zuweisung minimiert Leerlauf und maximiert Systemauslastung

Durch eine intelligente Lastanalyse ordnet k0rdent laufend CPU- und Speicherressourcen nach Echtzeitbedarf zu und optimiert so die Verteilung aller Workloads. Die automatische Steuerung passt Kapazitäten flexibel an Lastspitzen an und verhindert gleichzeitig Überprovisionierung. Dieses ressourcenorientierte Management maximiert die Serverauslastung und reduziert Kosten für zusätzliche Hardware. Gleichzeitig profitieren Anwender von einer stabilen Performance, ausgezeichneter Skalierbarkeit und verkürzten Deployments in Cloud-, Hybrid- oder On-Premises-Infrastrukturen. Der adaptive Ansatz steigert Effizienz und verringert Administrationsaufwand.

Automatisierte Bereitstellung über YAML-Templates senkt Zeitaufwand und steigert Effizienz

YAML-basierte Templates in Kombination mit einem webbasierten Self-Service-Portal erlauben es Entwicklern, Infrastrukturkomponenten wie VMs, Container-Netzwerke oder Speichervolumes eigenständig zu provisionieren. Über vorgefertigte Module werden Anforderungen definiert und automatisch ausgeführt, während integrierte Prüfungen Konfigurationsfehler schon im Vorfeld verhindern. Die automatisierte Pipeline verkürzt die Bereitstellungsdauer, sorgt für wiederholbare Prozesse und beschleunigt die Markteinführung neuer Produkte, ohne dass IT-Teams manuelle Konfigurationsschritte übernehmen müssen. Skalierung, Monitoring sowie Compliance-Checks sind integriert und unterstützen den Lebenszyklus.

Zentrale Plattform ermöglicht Portabilität identischer Anwendungen über jede Infrastruktur

Die k0rdent-Technologie konsolidiert Anwendungs-Pakete und Container-Images in einer einzigen Konfigurationsschicht, sodass mit identischen Artefakten Deployments auf AWS, Azure, GCP, in lokalen Rechenzentren und an Edge-Standorten möglich sind. Dank Kubernetes-basierter Automatisierung wird kein Code-Refactoring benötigt, um Microservices und KI-Workloads über verschiedene Infrastrukturen zu verschieben. Unternehmen erzielen dadurch höhere Betriebskontinuität, schnellere Rollouts, standardisierte Sicherheits- und Netzwerkregeln sowie verbesserte Ressourcennutzung ohne Infrastruktur-Silos. Dies führt zu geringeren Ausfallzeiten, vereinfachter Wartung und beschleunigtem Innovationszyklus nachhaltig.

Infrastrukturdefinition und Richtlinienkontrolle werden über k0s und GitOps ermöglicht

Die Kombination aus k0s als Open-Source-Lösung und GitOps-Workflows ermöglicht es, Infrastrukturänderungen in Git zu definieren, zu versionieren und automatisch umzusetzen. Durch zentral gesteuertes Policy-Enforcement bleiben Sicherheits- und Compliance-Vorgaben stets wirksam. Das Mirantis-Ökosystem liefert validierte Templates, die als geprüfte Best-Practice-Blueprints fungieren und eine standardisierte, reglementkonforme Infrastrukturdefinition garantieren. Offener Quellcode, regelmäßige Community-Updates und kommerzieller Support runden die Lösung ab und sichern langfristige Wartbarkeit. Entwickler-Communities können beitragen, Templates erweitern und von Shared-Services profitieren.

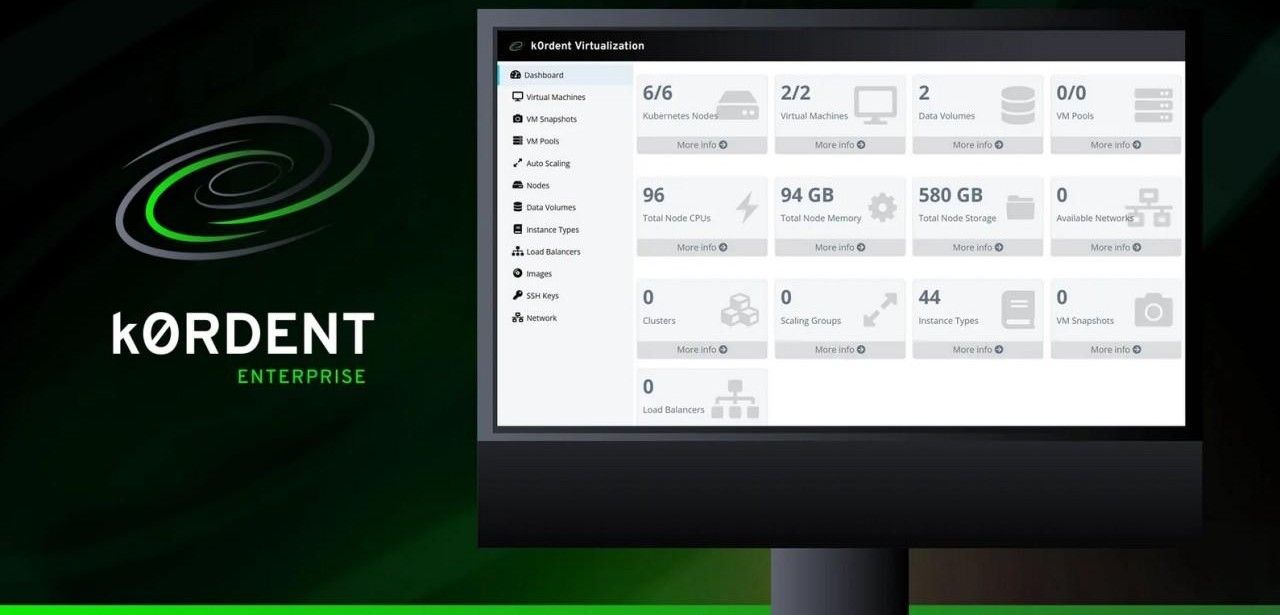

Geschwindige Migration von Legacy-Systemen mit k0rdent Virtualization unter Kubernetes

k0rdent Virtualization integriert sich nahtlos in k0rdent Enterprise und dient als schlüsselfertige VMware-Ersatzplattform. Alte Virtualisierungen werden ohne Kompatibilitätsbrüche in Kubernetes-Cluster absorbiert, wodurch sich heterogene Umgebungen schlank konsolidieren lassen. Die Lösung kombiniert VM-Hosting, Container-Orchestrierung und Netzwerkvirtualisierung in einer Oberfläche mit deklarativer Steuerung. Mit dynamischem Ressourcenmanagement, automatisierten Self-Service-Provisionierungen und Richtlinien-Governance erhöht sie Effizienz, Sicherheit und Agilität, während Wartungsfenster verkürzt und Betriebskosten signifikant reduziert werden. Integriertes Monitoring, API-Automatisierung, rollenbasierter Zugriffsschutz und mandantenfähige Architekturen.

Standardisierte YAML-Templates von Mirantis senken Komplexität effizient in Multi-Cloud-Umgebungen

Die Standardkonfigurationen von Mirantis für AWS, Azure, GCP, vSphere und OpenStack bieten einheitliche Parametersetups für Compute, Netzwerk und Storage. Sie reduzieren manuelle Eingriffspunkte durch automatisierte Prozesse und ermöglichen nahtlose Betriebsabläufe über hybride Cloud- und On-Premises-Infrastrukturen hinweg. Fehlerquellen werden minimiert, da bewährte Konfigurationsmuster vorliegen. In Kombination mit integrierten Rollback-Mechanismen und Versionskontrolle lassen sich Deployments zuverlässig orchestrieren und Compliance-Vorgaben einfacher einhalten. Performance-Optimierungen und Sicherheitsupdates ausgeliefert, Governance-Richtlinien automatisiert durchgesetzt, Self-Service-Portale unterstützen Teams. sofort.

YAML-basierte Templates und Self-Service-Portale beschleunigen die automatisierte Infrastruktur-Bereitstellung deutlich

Die Mirantis-Plattform k0rdent Enterprise mit k0rdent Virtualization bietet eine Kubernetes-native Basis für Container- und VM-Orchestrierung in Multi-Cloud-, Hybrid- und Edge-Infrastrukturen. Dank deklarativer Self-Service-Templates und GitOps-Pipelines automatisiert sie Provisionierung, Updates und Skalierung von Microservices, KI-Workloads und Legacy-Anwendungen. Ein intelligentes Scheduling sowie Self-Healing-Funktionen steigern Ausfallsicherheit und Ressourceneffizienz. Zentralisiertes Policy-Management sorgt für nachweisbare Compliance, während Entwickler und Betreiber schnell auf sich ändernde Anforderungen reagieren können. Kostenoptimierung, erhöhte Performance, verbesserte Skalierbarkeit und reduzierte Komplexität.